然而,随着技术的发展和 CPU 的性能提高,CPU 正在重新获得在 AI 开发中的地位。相比于 GPU,CPU 可以提供更好的能效比,处理多种任务,更具灵活性,并且更适合在云计算中运行。

此外,一些新兴技术如Intel的的Deep Learning Boost (DLB) 以及AMD的Infinity Fabric技术,也使得CPU在处理AI任务方面有了明显的进步。

尽管如此,GPU在处理某些类型的人工智能任务时仍然表现优异,特别是在需要大量并行计算的任务中。因此,在AI开发中,CPU和GPU之间仍然需要根据不同任务的需求来做出合适的选择。

总之,CPU作为一种不起眼但实用的硬件形式,正在重新攻克AI的领域。在未来,将会有更多的技术和硬件形式争夺AI开发的市场,这也将推动AI技术和应用的进一步发展。

“解锁 GPU 的大规模并行架构来训练深度神经网络是使深度学习成为可能的关键因素之一,”Simon说。

“然后 GPU 迅速集成到TensorFlow和PyTorch等开源框架中,使它们易于使用,而无需编写复杂的低级 CUDA 代码。”

计算统一设备架构(CUDA) 是 Nvidia 在 2007 年推出的应用程序编程接口 (API),作为其挑战 CPU 主导地位计划的一部分。

它在 2010 年代中期建立,为 TensorFlow 和 PyTorch 提供了一条清晰的途径来利用Nvidia硬件的力量。

Hugging Face 作为 AI 社区的中心枢纽(除其他外)提供与 TensorFlow 和 PyTorch 兼容的开源 Transformers 库,也在 CUDA 的发展中发挥了作用。

然而,Simon认为“垄断从来都不是一件好事”。GPU 的主导地位可能会加剧供应链问题并导致成本上升,英伟达2023 年第一季度财务业绩的井喷凸显了这种可能性,在人工智能需求的推动下,收益增长了 28%。

“在 AWS 或 Azure 上获得 [Nvidia] A100 几乎是不可能的。

那么,然后呢?Simon问。

“出于所有这些原因,我们需要一个替代方案,如果您愿意做功课并使用适当的工具,英特尔CPU 在许多推理场景中都能很好地工作。”

CPU 的无处不在为 GPU 的主导地位提供了一个变通办法。

PC 组件市场研究公司Mercury Research最近的一份报告发现,仅 2022 年一年,x86 处理器的出货量就达到了 3.74 亿个。

ARM 处理器更为常见,到 2022 年第三季度,芯片出货量超过 2500 亿颗。

AI 开发人员在很大程度上忽略了这一未开发潜力池,他们认为 CPU 相对缺乏并行处理能力将不适合深度学习,因为深度学习通常依赖于并行执行的大量矩阵乘法。

在 OpenAI 的GPT-3(1750 亿个参数)和 DeepMind 的Chinchilla(700 亿个参数)等模型的成功推动下,AI 模型规模的快速增长加剧了这个问题。

ThirdAI的首席执行官兼创始人Shrivastava Anshumali说:“对于模型和数据集的大小,即使有共同进化的软件和硬件生态系统,我们正处于基本的密集矩阵乘法变得令人望而却步的地步。”

它不一定是那样的。ThirdAI 的研究发现,现有 LLM 中“超过 99%”的操作返回零。

ThirdAI 部署了一种哈希技术来减少这些不必要的操作。“基于散列的算法消除了在无关紧要的零上浪费任何周期和能量的需要,”Anshumali 说。

他的公司最近通过 Pocket-LLM 展示了其技术的潜力, Pocket-LLM 是一款适用于 Windows 和 Mac 的人工智能辅助文档管理应用程序,可以在大多数现代笔记本电脑的 CPU 上轻松运行。

ThirdAI 还提供Bolt Engine,这是一种用于在消费级 CPU 上训练深度学习模型的 Python API。

Hugging Face 的 Q8-Chat 采取了不同的策略,通过一种称为量化的模型压缩技术实现了其结果,该技术将 16 位浮点参数替换为 8 位整数。这些不太精确但更容易执行并且需要更少的内存。

英特尔使用了一种特定的量化技术SmoothQuant,将 Meta 的LLaMA和 OPT等几种常见 LLM 的大小减少了一半。

公开的 Q8-Chat 演示基于MPT-7B,这是来自 MosaicML 的开源 LLM,具有 70 亿个参数。

英特尔继续为其即将推出的Sapphire Rapids 处理器开发 AI 优化,这些处理器用于 Q8-Chat 演示。

该公司最近为 Sapphire Rapids 提交的 MLPerf 3.0 结果显示,该处理器在离线场景下的推理性能提升是上一代 Ice Lake 的五倍以上。

同样,服务器场景的性能提升也是Ice Lake的十倍。

与之前提交的 Sapphire Rapids 相比,英特尔还展示了高达 40% 的改进,这是通过软件和“特定于工作负载的优化”实现的提升。

这并不是说 CPU 现在将在所有 AI 任务中取代 GPU。Simon 认为“总的来说,较小的 LLM 总是更可取”,但他承认“没有一种瑞士军刀模型适用于所有用例和所有行业。”

尽管如此,该阶段看起来仍会增加 CPU 相关性。Anshumali 特别看好这种潜在的转机,认为需要经过调整以处理特定任务的小型“领域专业 LLM”。

Simon 和 Anshumali 都表示,这些较小的 LLM 不仅效率高,而且在隐私、信任和安全方面也有好处,因为它们消除了依赖第三方控制的大型通用模型的需要。

Anshumali 说:“我们正在构建能力,将 CPU 的每个核心都发挥出来,为大众提供更好的 AI。” “我们可以用 CPU 使人工智能民主化。”

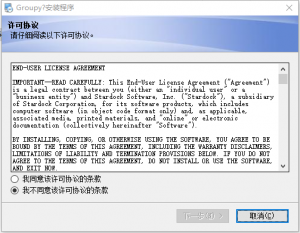

登录可免费下载软件

VIP可高速下载,支持百度、123网盘、蓝奏网盘等全站资源。

永久VIP可加入专属群,享受群内福利,享受1对1服务。

非VIP会员类型

分普通会员、黄金会员、钻石会员,不同会员的下载次数各不相同。

可通过积分兑换及签到获取积分。

联系客服

如链接失效或有其他问题,请联系客服微信:

diannaodiyquan 或 diannao10zv或者diy10zv

(备注:“电脑DIY圈”以防封号)

免责声明

1. 软件全部来源于网络,如有侵权请联系客服。

2. 本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

3. 本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报。

4. 本站资源大多存储在云盘,如发现链接失效,直接跟帖催更我们会第一时间回复。

暂无评论内容