很多人都在欢呼AI时代的到来,但其实AI这个概念早在20世纪50年代就诞生了,而且一直都在高速发展和演化,并不是什么新鲜事物。

只不过,几十年来,AI一直都基本停留在专业领域或者特定行业,距离普通用户比较遥远,一般人很难真切感受到AI的力量。

ChatGPT最大的功劳,恰恰是将AI——确切地说是生成式 AI(AIGC)——带到了普通人的生活中。

有了ChatGPT和类似的应用,任何人只需一部普通的电脑或者手机,就能感受到AI给我们工作生活、娱乐休闲所带来的种种便利——一问一答就能获得自己想要的问题答案、几分钟就能完成一份漂亮的PPT……

另一方面,虽然这个时候几乎人人都在谈论AI,从跨国大企业到初创小公司似乎一夜之间都在完全围着AI做事,但是正如巴菲特的那句名言:“只有退潮了,才知道谁在裸泳。”也只有经历最初的喧嚣,才能看出谁才是认真做AI,谁才真正有实力做好AI。

近日,Intel举办了一场年度技术创新大会,AI自然是关键词中的关键词,“AI Everywhere”不仅体现在整个大会上,也体现在Intel的全线产品和解决方案中,这个话题我们之前也从不同角度探讨过很多次。

当然,作为软硬件实力都在这个星球上属于顶级行列的Intel,自然也是最有资格谈论AI的巨头之一。

正如刚才所说,AI无处不在,从产品到技术再到应用都有截然不同的丰富场景,普通用户能够最直接感受到的当属AIGC,包括文生文、文生图、图生图、文生视频、图生视频等等。

而要想实现足够实用的AIGC,从算力强大的硬件到参数丰富的大模型,从精确合理的算法到高效便捷的应用,缺一不可。

我们知道,在过去,AIGC更多在云侧服务器上,虽然性能、模型、算法都不是问题,但一则需要大量的资金投入,二则存在延迟、隐私等方面的不足。

因此,AIGC正越来越多地下沉到终端侧,让普通的PC电脑、智能手机也能跑AIGC,甚至可以离线执行。

Intel中国技术部总经理高宇先生在接受采访时就表示,关于终端侧运行AIGC的研究已经取得了丰硕的成果,比如最新的13代酷睿电脑,经国有化已经可以流畅运行70亿到180亿参数的大模型,尤其是70亿到130亿参数的运行效果相当好。

当然这些现在还处于起步阶段,目前的优化主要针对CPU处理器,下一步会充分发挥GPU核显的性能潜力,而代号Meteor Lake的下一代酷睿Ultra除了有更强的CPU、GPU算力,还会首次集成NPU单元,一个专用的AI加速器,峰值算力超过11TOPS,三者结合可以达到更好的效果。

对于PC端侧运行AIGC应用的具体落地实现,高宇举了个例子,Intel正在打造的一个开源框架BigDL-LLM,专门针对Intel硬件的低比特量化设计,支持INT3、INT4、INT5、INT8等各种低比特数据精度,性能更好,内存占用更少。

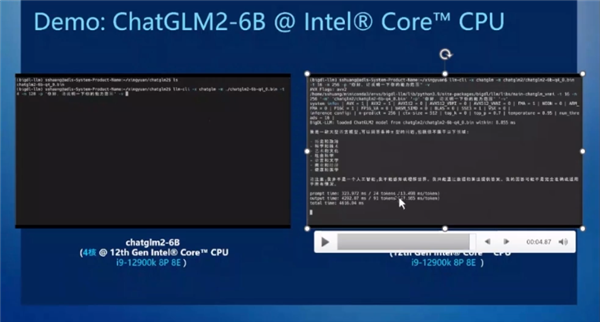

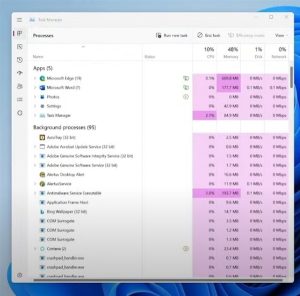

基于这个框架,使用i9-12900K处理器,只开启4个核心来运行ChatGLM2 60亿参数模型,生成效果就是相当迅速的,而打开全部8个P核、8个E核,效果更是堪称飞快,输出性能达到了每个Token 47毫秒左右,已经不弱于很多云侧计算。

之所以对比两种情况,因为有时候需要将全部算力投入AI模型的运算,而有时候可能还得兼顾其他任务。

可以看出,无论哪种情况,Intel PC侧都已经可以很好地完成相应的AI工作,提供令人满意的算力和效率。

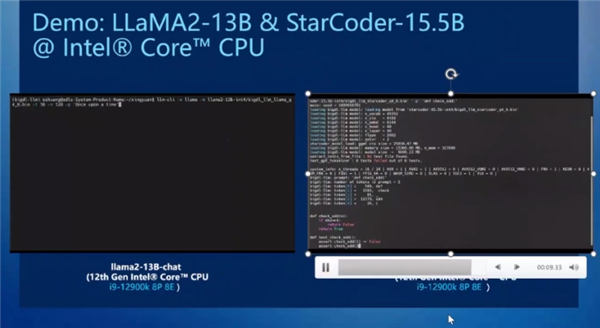

此外,在LLaMA2 130亿参数大语言模型、StarCoder 155亿参数代码大模型上,Intel酷睿处理器也都能获得良好的运行速度。

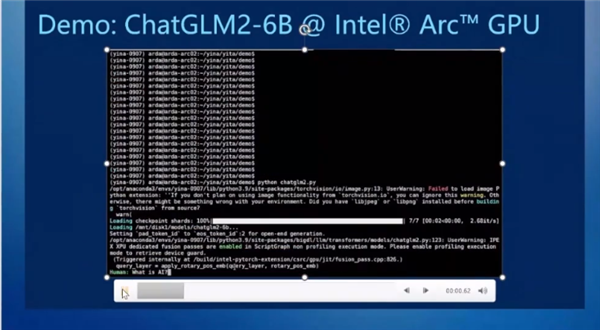

换到Arc GPU显卡上,Intel硬件跑端侧AI同样神速,甚至更快,无论是ChatGLM2 60亿参数,还是LLaMA2 130亿参数、StarCoder 155亿参数,都是如此,ChatGLM2模型中甚至可以缩短到20毫秒以下。

当然,以上说的大模型可能距离普通人还有些远,而任何一项技术要想大范围普及,关键还是颠覆用户的切身工作、生活、娱乐体验,AI当然也不例外。

在高宇看来,基于以上大模型,AI在端侧的典型应用还是相当丰富的,而且会越来越多,有时候效果会更胜于运行在云侧。

比如超级个人助手,通过低比特量化,在PC侧可以获得更好的效果。

比如文档处理,包括中心思想提炼、语法错误纠正等等,PC侧不仅可以很好地运行,还有利于保护个人隐私和数据安全。

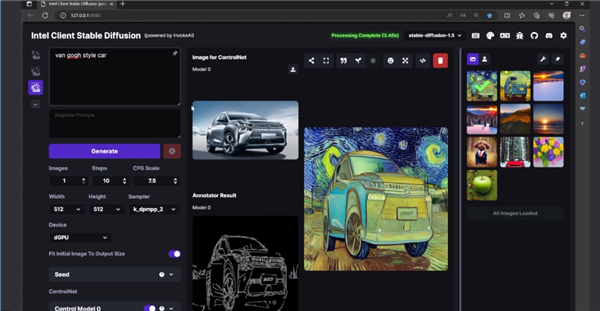

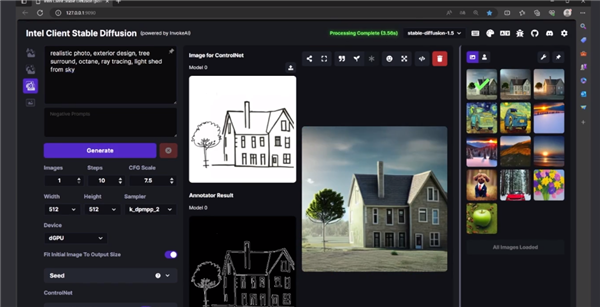

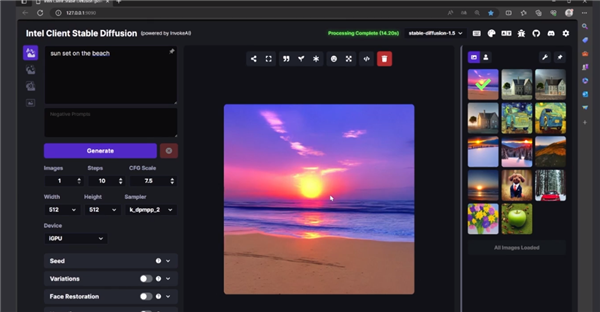

再比如如今大火的Stable Diffusion和衍生模型的文生图、文生视频应用,PC侧的算力也是足够的。

使用Arc A730M这样的笔记本独立显卡,就可以在几秒钟内完成高质量的文生图、图生图、图像风格转换等,从而极大地节省工作量,将更多精力放在创意上。

这足以证明,一台普通的笔记本在端侧运行大模型,使用普通独显甚至集显,依然可以获得足够快的响应速度和良好的体验,当然这也得益于Intel的专项优化。

当然,归根到底,AIGC应用在PC端侧的普及,离不开足够多、足够好用的生态软件。

这样的软件,一方面可以来自各种商业软件,他们本身就可以集成中小尺寸大语言模型,提供各种AIGC内容,一些创作软件甚至可以集成Stable Diffusion。

另一方面可以来自各家PC OEM品牌厂商,在自己的电脑中集成专门开发、优化的AIGC软件,预装提供给用户,让AIGC真正可用。

当然,端侧运行AIGC也不是万能的,一是算力不像云端那么强大,二是内存有限。

目前主流内存容量还是16GB,哪怕明后年普及32GB,可以承受的模型参数量也是有限的(130亿以下),这就需要进行低比特处理,比如FP16转成INT4,还好在大语言模型中的问题回答质量只会有个位数的稍许下降,而在Diffusion模型中参数又不是很大,可以继续跑FP16精度。

事实上,AI研究虽然已经取得相当丰富的成果,未来必然影响每个行业、每个人,但AI依然处在早期阶段,广泛的AI工作负载涉及到不同的模型规模、模型类型、整体基础架构的复杂性,还要面临云侧、端侧、混合等不同环境的适应性,这些都要持续探索和优化。

相信随着像Intel这样有实力的大企业不但在AI应用上取得突破,尤其是将越来越多的AIGC应用带到端侧,让越来越多的人感受到AI的魅力,它必然会更加广泛、细致地深入我们的工作和生活,成为人们日常不可或缺的一部分,甚至在不知不觉中享受AI带来的便利。

这,才是技术造福人类的本源。

(图源:Pixabay)

登录可免费下载软件

VIP可高速下载,支持百度、123网盘、蓝奏网盘等全站资源。

永久VIP可加入专属群,享受群内福利,享受1对1服务。

非VIP会员类型

分普通会员、黄金会员、钻石会员,不同会员的下载次数各不相同。

可通过积分兑换及签到获取积分。

联系客服

如链接失效或有其他问题,请联系客服微信:

diannaodiyquan 或 diannao10zv或者diy10zv

(备注:“电脑DIY圈”以防封号)

免责声明

1. 软件全部来源于网络,如有侵权请联系客服。

2. 本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

3. 本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报。

4. 本站资源大多存储在云盘,如发现链接失效,直接跟帖催更我们会第一时间回复。

暂无评论内容