软件介绍

KoboldCpp 是一款易于使用的人工智能文本生成软件,主要用于 GGML 和 GGUF 模型。它是一个自包含的版本,基于 llama.cpp 开发,提供多种功能和灵活的用户界面,适合各种显卡和 CPU 使用。以下是主要特点和功能的总结:

主要特点:

- 易于上手:无需复杂的环境设置或代码,简单安装后即可使用。

- 显卡兼容性:最佳支持 NVIDIA 显卡,AMD、英特尔和苹果显卡也支持;即使没有显卡,CPU 也可以运行。

- 多功能 API:包含 Kobold API 端点,支持多种输出格式,提供稳定的图像生成和向后兼容性。

- 高级用户界面:提供持久故事、编辑工具和各种保存格式,支持人物、场景等管理。

功能:

- 简化版的 GPT:可用作简化版的文本生成模型。

- 角色扮演:进行AI角色扮演,如创建AI女友等。

- 文字冒险:设定一个虚拟世界并展开冒险。

版本:

- koboldcpp_cu12:针对新款NVIDIA显卡优化,速度快。

- koboldcpp:适用于老款NVIDIA显卡和其他品牌显卡。

- koboldcpp_nocuda:可以在没有显卡的情况下使用CPU运行。

加速选项:

- CuBLAS:适用于NVIDIA GPU,启动时使用,需安装CUDA工具包。

- CLblast:适用于大多数GPU(NVIDIA、AMD、Intel),启动时使用,需安装CLBlast库。

- OpenBLAS:仅限CPU使用,默认自动配置。

- Metal:仅适用于Apple Silicon,使用Metal进行GPU加速。

- Accelerate:仅适用于Mac用户的CPU加速,速度快于OpenBLAS。

- ROCm:针对AMD设备的支持,需使用 HIPBLAS。

- Vulkan:提供良好的速度和效用平衡的新选项。

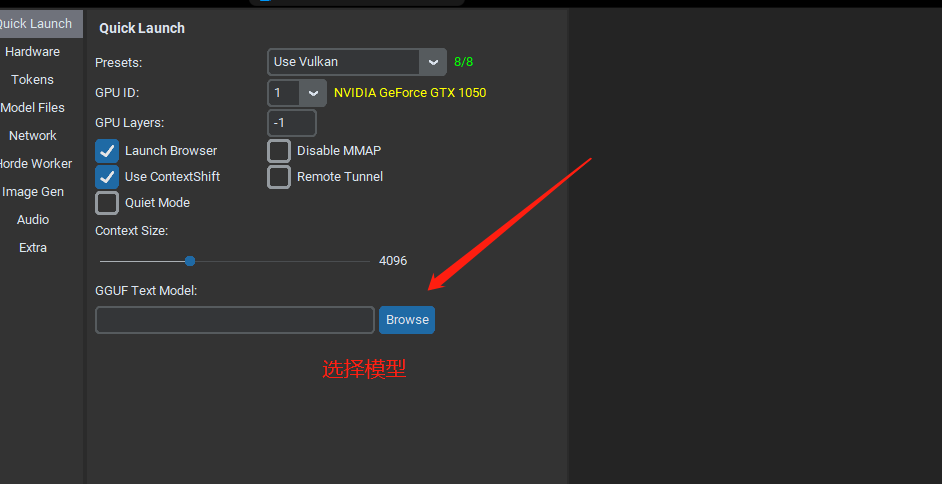

运行方法:

用户可以直接运行可执行文件(.exe),在设置中选择显卡模式以加速运行。

运行以后选择自己的模型

大家可以去huggingface.co下载,国内镜像HF-Mirror – Huggingface 镜像站

我放了几个模型 在model文件夹里面

模型选择的话既然是零基础,就搜GGUF,这类的都能简单粗暴直接跑,(GGML类也支持)体量上按自己的硬件来选择

模型体量和显存大概的关系

LLAMA 3B 至少需要 4GB RAM

LLAMA 7B 至少需要 8GB RAM

LLAMA 13B 至少需要 16GB RAM

LLAMA 30B 至少需要 32GB RAM

LLAMA 65B 至少需要 64GB RAM

软件获取

登录可免费下载软件

VIP可高速下载,支持百度、123网盘、蓝奏网盘等全站资源。

永久VIP可加入专属群,享受群内福利,享受1对1服务。

非VIP会员类型

分普通会员、黄金会员、钻石会员,不同会员的下载次数各不相同。

可通过积分兑换及签到获取积分。

联系客服

如链接失效或有其他问题,请联系客服微信:

diannaodiyquan 或 diannao10zv或者diy10zv

(备注:“电脑DIY圈”以防封号)

免责声明

1. 软件全部来源于网络,如有侵权请联系客服。

2. 本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

3. 本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报。

4. 本站资源大多存储在云盘,如发现链接失效,直接跟帖催更我们会第一时间回复。

暂无评论内容